3D Modellierung

Ausarbeitung zum Schwerpunktseminar

von

Bernhard Garthe

Einleitung / Bilder und Abbilder

Seit jeher versucht der Mensch, sich ein Abbild seiner Umgebung zu machen. In grauer Vorzeit standen ihm dazu nur

natürliche Hilfsmittel zur Verfügung. Felswände und Kohlestücke waren die einzige Möglichkeit, Geschehenes anderen

mitzuteilen. Später kamen Farben hinzu und die Abbilder konnten der Wirklichkeit mehr und mehr angenähert werden.

Die Fotografie und die Möglichkeit bewegte Bilder aufzunehmen perfektionierten die Weitergabe optischer Informationen.

Seit einigen Jahren verändert sich das Medium Bild entscheidend durch den Einsatz des Computers. Es ist nicht nur

möglich vorhandene Bilder zu verändern, sondern auch die Erstellung von neuen künstlichen Bildern ist mit Hilfe

eines Computers ein leichtes Unterfangen. Diese Bilder können in einer Qualität erzeugt werden, die es zum Teil schwierig

macht, tatsächlich Existierendes von Erfundenem zu unterscheiden.

Diese neuen Werkzeuge erweitern das Betätigungsfeld von Fotografen Technikern und Künstlern in gleichem Masse. Leider

scheuen sich immer noch manche das Potential von "3D" für sich zu Nutzen. An dieser Stelle soll dieses Seminar ansetzen, und

einen ersten Einblick in den Umgang mit 3D-Software zu geben.

Modellierung

Bei der eigentlichen "Modellierung" der Objekte geht es in erster Linie um die Form. Das heißt es muss bestimmt werden,

wie die Oberflächen des Objekts im Raum liegen. Es gibt einige Grundbestandteile ohne die kein 3D-Programm und auch die

daraus resultierenden Modelle auskommen.

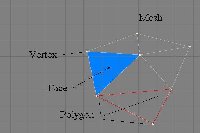

Ein Modell besteht im Kleinsten aus diesen 3 Komponenten

- Vetices

- Polygone

- Flächen (Faces)

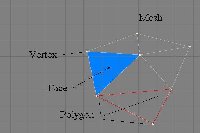

Mesh, Polygon, Face und Vertex

Vertex

Für all diejenigen die bisher nur mit Pixelorientierter Software gearbeitet haben gilt es sich den Unterschied zwischen

einem Pixel und einem Punkt klar zu machen. In einem Bild ist der Pixel das Kleinste Element und hat je nach gewählter

Bildschirmauflösung eine gewisse Größe. Beim Zoomen wächst dieser Pixel, bis er schließlich eine Rechteckige Form annimmt

und deutlich zu erkennen ist. Ein Punkt, oder Vertex, ist ein mathematisches Gebilde das eine Koordinate beschreibt, also einen

x-,y- und z-Wert besitzt. Ein Vertex bleibt auch bei starkem Zoomen immer nur ein Punkt.

Polygon

Dies führt uns zu dem nächsten Grundelement im 3D-Raum, dem Polygon. Ein Polygon besteht aus mindestens drei Punkten

(Vertices), wobei die Punkte so miteinander verbunden sind, daß dazwischen eine Fläche entsteht, also im einfachsten Fall

ein Dreieck.

Erst durch eine geschlossene Form kann eine Fläche beschrieben werden und nur Flächen können bei der Darstellung des

3D-Bildes berechnet werden. Natürlich können Polygone auch aus mehr als 3 Vertices bestehen, diese können von der Software

in Polygone mit 3 Vertices umgerechnet werden. Der Grossteil der 3D-Software arbeitet standardmäßig mit 3-Vertice Polygonen.

Was im Resultat keinen Unterschied macht, dar Polygone nur während der Modellierung angezeigt werden und im späteren Bild

unsichtbar sind.

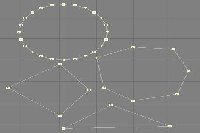

Polygone mit versch. Anzahl Vertices

Face

Das Face ist eigentlich nur ein Teil eines Polygons. Als Face Bezeichnet man die Fläche die von einem Polygon aufgespannt wird.

Das heißt, das Face ist von dem Polygon abhängig, außerdem wird die sichtbare Seite des Face über die Polygonpunkte festgelegt.

Ein Face ist nur von einer Seite sichtbar, es gibt eine Sichtbare Vorderseite und eine unsichtbare Rückseite. Zu jedem Face gehört

ein Normalvektor der sich aus den Vertices berechnen lässt, dieser Vektor gibt an welche Seite des Face die sichtbare ist. Auf

dieser Seite wird dann auch nur eine Farbe oder Textur angezeigt.

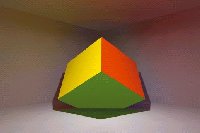

Mesh

Das Mesh ist das Polygongitter das die Form eines Objekts beschreibt. Das Mesh besteht aus zusammengestzten Polygonen und

beschreibt so auch voluminöse Körper. In 3D-Software gibt es sehr viele Möglichkeiten Meshs zu Verformen und zu bearbeiten,

diese Funktionen stellen meist den ersten Schritt bei der Modellierung dar.

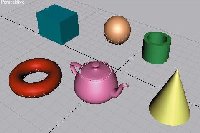

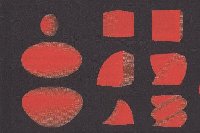

Grundkörper

Bei allen mathematisch exakten Körpern ist es natürlich undenkbar, Stunden damit zu verbringen, Punkte in den 3D-Raum zu

setzen und durch die Verbindung eben dieser so etwas Triviales wie z.b. eine Kugel zu definieren. Die Lösung ist das Arbeiten mit

sogenannten Grundkörpern. Grundkörper sind Objekte, die bereits fertig gebaut sind und einfach durch einen Mausklick auf deren Symbol ausgewählt werden können. Oftmals

muß der Anwender noch einige Zahlenwerte eingeben, um z.b. die Größe einer Kugel oder das Seitenverhältnis eines Quaders vorzugeben.

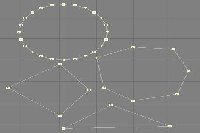

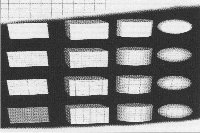

Bei Grundkörpern mit gebogenen Flächen wird man zudem noch gefragt, wie fein das Modell unterteilt werden soll. Machen wir uns dies am Beispiel

eines Kreises deutlich, auch ein typischer Grundkörper:

Wie wir alle wissen, ist die Quadratur des Kreises, also die Beschreibung eines Kreises mit der Hilfe von linearen Algorithmen,

unmöglich. Doch «runde Vektoren» gibt es nicht. So muß jede Krümmung durch gerade Teilstücke beschrieben werden. Dies bedeutet,

daß ein Kreis, der aus Punkten besteht, die mit geraden Linien verbunden sind, niemals wirklich rund sein kann. Je mehr Punkte

jedoch den Kreis aufziehen, d.h. je kleiner die geraden Teilstücke werden, desto runder wirkt der Kreis auf den Betrachter. Warum

nimmt man nun nicht einfach eine Million Punkte auf einer Kreisbahn und verbindet sie? Das Ergebnis wäre sicherlich ein nahezu

perfekter Kreis. Doch Vorsicht, die vielen Vertices sind Speicherfresser und kosten bei der Darstellung viel Performance, daher sollte

die Anzahl der Vertices möglichst klein gehalten werden.

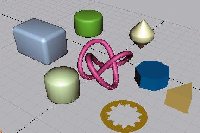

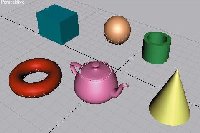

In den einzelnen 3D-Programmen steht Ihnen eine ganz unterschiedliche Zahl von Grundkörpern zur Verfügung. Neben Dreiecken,

Vierecken, Mehrecken, Quadern, Kreisen, Kugeln, Zylindern, Pyramiden und ähnlichen Formen zählen einige Hersteller auch exotischere

Gebilde, wie z.b. Fußbälle, Wendeltreppen, Kaffeekannen oder Schrauben dazu.

Die wichtigsten Grundkörper

Wozu braucht man diese Vielfalt an Grundkörpern? So gut wie jeder Gegenstand lässt sich aus Grundkörpern zusammensetzen. Um diese

Zusammensetzungen möglichst einfach zu gestalten liefert 3d-Software meist mehrere Duzend Grundkörper mit. Das Zusammensetzen gilt

insbesondere für viele technische Objekte. z.b. ein Bleistift: Vorn eine Pyramide, bzw. ein Kegel, in der Mitte ein Zylinder

und um die Sache abzurunden, hinten eine Halbkugel. Auf ähnliche Weise lassen sich sehr viele Dinge in kleinere Einheiten unterteilen,

die unseren Grundkörpern ähneln.

Natürlich liefert diese Technik - leider — nicht immer befriedigende Ergebnisse. Wer jedoch in der Lage ist, komplexe Objekte durch

einfache Formen zu beschreiben, hat allen anderen immer etwas voraus, und sei es nur, daß er schneller mit seiner Arbeit fertig ist.

Verbinden von Grundkörpern

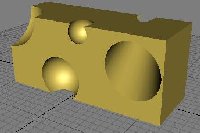

Boolesche Operationen

An erster Stelle seien die Booleschen Operationen genannt. Sie sind ein sehr mächtiges Werkzeug, um komplexe Objekte aus einfachen

Körpern zusammenzusetzen. Als Mengenoperationen sind sie Teil der Mengenlehre.

Bei der Boolschen Operation wird ein Objekt zu einem anderen addiert, subtrahiert oder die Schnittmenge beider gebildet. Mit Hilfe

dieser recht einfach wirkenden Funktionen wird die Menge der mit Grundkörper darstellbaren Objekte deutlich erhöht. Durch gezielte

Anwendung lassen sich komplex wirkende Modelle auf sehr einfache Art erzeugen.

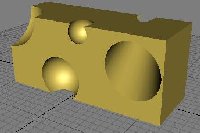

Aus 2 Objekten wird mit Boolschen Funktionen ein Objekt berechnet

Käse, ein einfaches Beispiel

Hierarchische Verknüpfungen

Die zweite Möglichkeit geht einen anderen Weg. Es handelt sich dabei um die Verkettung von Objekten. Dabei fungiert ein Objekt als

sogenanntes Elternteil (Parent). Beliebig viele andere Objekte (Child) werden dem Parent-Objekt untergeordnet, quasi an die Hand

gegeben. Jede Positionsänderung des Parent-Objekten wird nun automatisch von den Child-Objekten nachvollzogen. Maßgeblich ist für

alle Unterobjekte die Lage des Schwerpunktes des Parent-Objektes.

Hierarchisch verknüpfte Objekte behalten Ihre relative Position

Diese Technik ist den Booleschen Funktionen bei Verknüpfungen deshalb überlegen, da alle Beziehungen zwischen den Objekten jederzeit

wieder gelöst werden können. Außerdem müssen die Objekte sich nicht berühren. Auch später bei der Texturierung bringt diese Technik

Vorteile. Viele Programme bieten zusätzlich zu der Möglichkeit des gemeinsamen Rotierens noch andere Manipulationen an. So werden

z.b. Größenänderungen des Parent-Objektes ebenfalls auf die Child-Objekte übertragen, so daß alle Größenverhältnisse einer Gruppe

erhalten bleiben. Auch kann das Parent-Objekt beliebig im Raum verschoben werden, und die Child-Objekte folgen entsprechend.

Grundfunktionen

Extrude-Tool

Das erste Werkzeug heißt Extrude-Tool und bewirkt eine Verschiebung der vorher erstellten Kurve entlang einer Achse. Es findet keine Rotation

oder Skalierung statt. Ein Anwendungsbeispiel wäre die Modellierung eines T-Trägers. Ein T-förmiges Profil wird dabei auf eine bestimmte

Länge beibehalten. Es wird nur die Länge eingegeben, die das Profilstück haben soll, und die Software dupliziert Ihr Profil im gewünschten

Abstand auf der gewünschten Achse und verbindet die beiden Querschnitte miteinander. Ein massiver Körper entsteht.

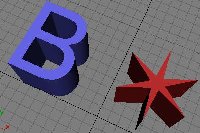

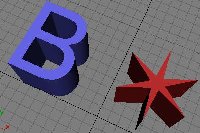

Diese Funktion wird z.b. auch bei Buchstaben angewendet, die eine gewisse Tiefe haben sollen. Sie geben z.b. den Umriß eines Buchstaben mit Splines

vor und lassen dann das Profil extrudieren. Oftmals gibt Ihnen die Software nach Abschluß der Funktion die Möglichkeit, die sonst offenen

Profile vorn und hinten als geschlossene Flächen darzustellen. So entsteht der Eindruck eines kompakten und massiven Körpers.

Anwendungsgebiete: 3D Buchstaben, Profilteile, ...

3D Buchstaben mit Extrude

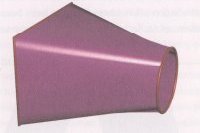

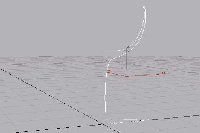

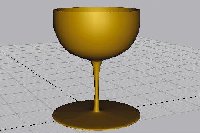

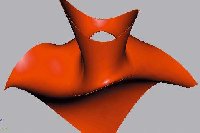

Lathe-Tool

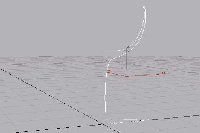

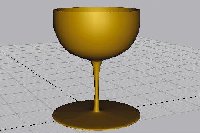

Der Name kann wie gewohnt in den einzelnen Programmen variieren, die Funktion ist jedoch in jedem Programm enthalten. Dabei wird eine offene

oder geschlossene Kurve, die z.b. mit Splines erzeugt wurde, um eine vorher festzulegende Achse im Raum gedreht und dabei dupliziert.

Die Schrittweite bzw. die Gradzahl, die zwischen den Duplikaten liegt, kann vorgegeben werden. Je kleiner die Schrittweite, desto feiner wird

das Endresultat. Das Tool verbindet abschließend alle Kurven miteinander und erzeugt somit eine Oberfläche. Die vorgegebene Spline-Kurve ist

zum Profil eines Rotationskörpers geworden. So lassen sich kinderleicht rotationssymmetrische Körper, wie z.b. Vasen, Gläser, Flaschen,

Autoreifen oder auch CDs, erstellen. Einfach ein Profil erstellen, um die Symmetrieachse rotieren lassen und fertig ist ein komplexer Körper,

der danach natürlich mit den bereits beschriebenen Tools weiterbearbeitet werden kann.

Zu beachten ist aber, daß geschlossene Flächen bei der Rotation um eine Achse nur entstehen können, wenn ein Punkt der Kurve direkt auf der

Rotationsachse liegt, wenn dies nicht der Fall ist entsteht ein Körper mit einem Loch in der Mitte.

Anwendungsgebiete: Vasen, Säulen, Schachfiguren, Gläser, ...

Ein einfaches Beispiel: Gläser mit Lathe

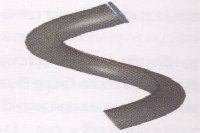

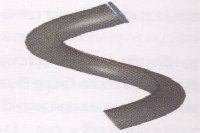

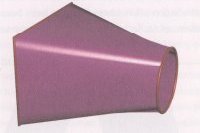

Sweep-Tool

Eine artverwandte Funktion verbirgt sich im sogenannten Sweep-Tool, das auch in fast allen Software Paketen angeboten wird. Hierbei wird ebenfalls

eine vorgegebene Kurve um eine Achse rotiert, dabei dupliziert und verbunden. Diesmal hat man jedoch die Möglichkeit, die Profilkurve im

Verlauf der Rotation zu verändern. Die Kurve kann z.b. kleiner oder größer werden oder auf Rotationsachse wandern. Auf diese Art und Weise

lassen sich z.b. Schneckengehäuse oder Schraubgewinde erzeugen.

Die gewünschte Schrittweite in Grad und damit die Genauigkeit, mit der der Körper erstellt wird, kann wie beim Lathe-Tool verändert werden.

Schaltet man die Verschiebung der Kurve auf der Achse aus und deaktiviert eine Skalierung, erhält man also die gleichen Ergebnisse wie mit

dem bereits beschriebenen Lathe-Tool.

Anwendungsgebiete: Schrauben, Schneckenhäuser, ...

Sweep Beispiele

Erweiterte Funktionen

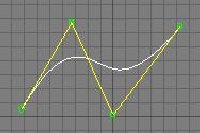

Nurbs (Non-Uniform Rational B-Splines)

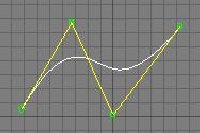

Nurbs sind Kurven, die durch Punkte gesteuert werden. Erinnere man sich an Splines: eine Kurve wird erzeugt, die fließend ohne scharfe Kanten

exakt durch die von Ihnen vorgegebenen Punkte verläuft. Bei den Nurbs-Kurven habt man keine Möglichkeit, diese Durchgangspunkte direkt zu setzen.

Statt dessen bekommt man mehr Kontrolle über den Verlauf der Kurve, denn die Punkte, die man setzt, verhalten sich zu der entstehenden

Kurve wie Steigungsvektoren. Verbindet man also den ersten und zweiten vom Benutzer gesetzten Punkt, so liegen diese auf einer Linie, die die Steigung

der Kurve im ersten Punkt bestimmt. Bei nur zwei gesetzten Punkten wird sich also wieder eine gerade Linie ergeben. Das Bild ändert sich jedoch

schlagartig, wenn ein dritter Punkt hinzukommt, denn nun muß die Kurve sich nicht nur der Steigung zwischen Punkt eins und zwei beugen, sondern

die Steigung zwischen Punkt zwei und drei nimmt ebenfalls Einfluß auf deren Verlauf. Nun wird auch klar, daß die Kurve bei mehr als zwei gegebenen

Punkten nicht mehr exakt durch all diese verlaufen kann. Der riesige Vorteil dieser zuerst kompliziert und umständlich erscheinenden Methode ist

die Kontinuität des Kurvenverlaufs, auch nachdem einzelne Punkte verschoben wurden. Da die Punkte nur Steigungen vorgeben und die Kurve somit nicht

zu ungewollten «Schlenkern» zwingen können (wie es bei Splines möglich ist), können organisch weiche und fließende Oberflächen leichter definiert

werden. Sehr vorteilhaft ist auch, daß Nurbs ihre Eigenschaften auch im Flächenverbund behalten. So können auch nachträglich noch Veränderungen

an Nurbs-Modellen vorgenommen werden, die mit reinen Polygonmodellen nicht möglich wären, da diese Manipulationen direkt an den Polygonen und nicht

an den Steigungsvektoren der Flächen vorgenommen werden. Außerdem können Nurbs-Objekte auch gebogene Polygone enthalten, also Flächen, die wie normale

Polygone aus drei oder vier Eckpunkte bestehen, wobei die Verbindungen jedoch gekrümmt sein können.

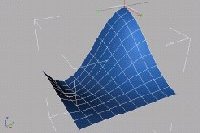

2D Nurb

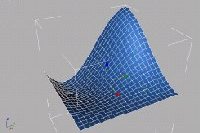

Modellierung mit Nurbs

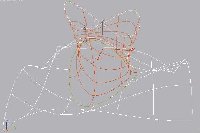

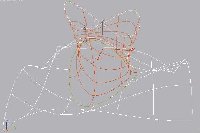

Skinning

Das wohl mächtigste Werkzeug in bezug auf Splineprofile. Mit ihm lassen sich eigentlich alle Vorstellbaren Resultate erzeugen und läßt sich jedoch sehr flexibel

einsetzen. Man kann beliebig viele, kreuz und quer im Raum liegende Kurven und Profile miteinander verbinden. Diesen Prozeß bezeichnet man als Skinning

(Aufziehen einer Haut).

Die vorgegebenen Kurven fungieren dabei als eine Art Stützkorsett, über das die Software eine anschmiegsame Hülle streift. Sie können also an jeder

beliebigen Stelle einen Querschnitt vorgeben. Runde Rohre lassen sich damit z.b. in ein Vierkant überführen, und zwar mit fließenden Übergängen.

Ist man sich erst einmal über die Möglichkeiten dieses Tools klar geworden, erkennt man, daß man fast jeden beliebigen Gegenstand mit der Unterstützung

dieser Funktion modellieren kann. Ein Gesicht läßt sich genauso in scheibenförmige Profile zerlegen wie ein Auto oder eine Computermaus.

Auch bei diesem Werkzeug hilft Ihnen wieder der richtige Blick für einen Gegenstand. Wie auch schon bei den Grundkörpern sollte man sich, vor der

Arbeit, den zu Modellierenden Gegenstand, verinnerlichen.

Einfaches Verbinden von Profilen

Modellierung mittels Querschnitten und Skinning

Dieses Werkzeug ist einfach zu handhaben, hat aber auch seine Schwächen. So führt z.B eine Überführung eines 5-Eck Profils in ein 6-Eck nur in den seltensten

Fällen zum gewünschten Resultat. Vielmehr wird ein Körper entstehen bei dem an einer Stelle die Polygone seltsam übereinander liegen, und unschöne

Effekte verursachen. Dies liegt daran, daß diese Funktion versucht den ersten Punkt der Kurve 1 mit dem ersten Punkt der Kurve 2 zu verbinden. Dies kann

bei unterschiedlicher Anzahl von Punkten zu Problemen führen. Um solche Probleme zu vermeiden sollte man darauf achten, daß die zu verbindenden Kurven die

gleich Anzahl an Punkten besitzen.

Patch-Modellierung

Was ist ein Patch? Der Unterschied zwischen einem Polygon und einem einzelnen Patch ist schnell erklärt. Ein Patch besitzt wie ein Polygon Vertices

und Kanten. Während bei Polygonen die Kanten immer eine Gerade darstellen, bestehen die Kanten eines Patches aus Shapes mit zwei Eckpunkten. Diese

Eckpunkte besitzen zur Steuerung, wie Bezier Splines auch, sog. Handler, die man bewegen kann. Somit lassen sich durch ein einzelnes Patch Flächen

aufbauen, die nur mit mehreren Polygonen zu erstellen wären. Und genau das macht ein Patch. Die Fläche zwischen den Kanten wird mit Polygonen aufgespannt,

deren Anzahl sich verändern lässt.

Polygon mit geraden Kanten im Vergleich mit Patches

Anwendung Patches

Diese Modellierungsart erfreut sich sehr grosser Beliebtheit und gehörte auch schon zu Beginn der 3D-Software in den Rahmen was 3D-Software leisten

können musste. Für einen Anfänger ist es ein wenig ungewohnt mit dieser Art des Modellierens zu arbeiten, aber aufgrund der Möglichkeiten sollte man

auf keinen Fall darauf verzichten.

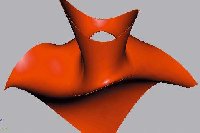

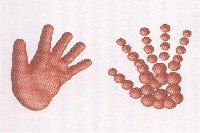

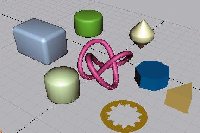

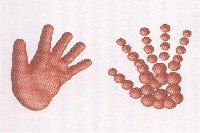

Metaballs

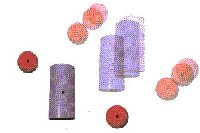

Auf dem gleichen mathematischen Hintergrund basierend haben sich mehrere neue Modellierungstechniken entwickelt. Besonders interessant ist dabei

das Metaballs-Konzept. Hierbei wird ein Körper nicht mit Kurven beschrieben, die dann manipuliert werden, sondern man modelliert mit Kugeln.

Mittlerweile werden unsere bekannten Grundkörper von den meisten Programmen auch als Metaobjekte eingesetzt.

Für sich allein gesehen ist eine Metaball-Kugel, die einsam und allein im 3D-Raum steht, nichts weiter als eine Kugel. Interessant wird die Sache erst,

wenn wir eine zweite Kugel daneben legen. Plötzlich stülpen sich beide Kugeln an den der Nachbarkugel zugewandten Seite aus und verschmelzen dort.

Ganz ähnlich verhalten sich z.b. Wassertropfen, die ineinander fließen. Der Vorteil der Metaballs ist, daß ihre Position erhalten bleibt. Aus zwei

Kugeln ist somit so etwas wie eine längliche Pille oder Kapsel geworden. Wenn man nun dieses Experiment weiterspinnt, so wird man schnell den

unglaublichen Vorteil erkennen, den diese Modellierungstechnik mit sich bringt. Sie brauchen sich keine Gedanken mehr um Splines, Kurven oder

Polygone zu machen. Auch das ewige Problem der Verbindung mehrerer Körper in einem weichen Übergang entfällt. Gruppieren Sie z.b. zehn bis fünfzehn

Kugeln zu einem Viereck und legen Sie noch ein paar weitere hinzu, die in einer Linie auf die Viereckgruppe stoßen. Die Kugeln laufen ineinander.

Man legt weitere längliche Kugelgruppen hinzu, und eine Hand entsteht. Sie werden keine unschönen Übergänge an den Fingern entdecken können,

und vor allem können Sie jederzeit z.b. einen Arm aus Kugeln hinzumodellieren. Die beiden Elemente Hand und Arm werden perfekt verschmelzen. Es

handelt sich um einen völlig neuen Ansatz, 3D-Körper zu erstellen. Die schon erwähnten neuen Metaobjekte machen die Anwendung noch einfacher, da

nun gleich die zur Endform passenden Grundkörper zur Modellierung eingesetzt werden können. Man möchte einen Fön modellieren. Man könnte dies natürlich

konventionell über Spline-Kurven verwirklichen, die entsprechend angeordnet verbunden werden müssen. Viel einfacher ist es allerdings, einen

horizontalen und einen vertikalen Zylinder so einander anzunähern, daß sie an den Berührungspunkten verschmelzen und ein natürlich verlaufender

Übergang entsteht.

Einfaches modellieren natürlicher Formen mit Metaballs

Chaos durch Metaballs (erster eigener Versuch)

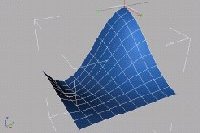

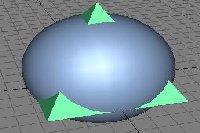

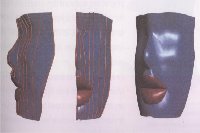

Freiform Deformation (FFD)

Bei diesen FFDs handelt es sich um Quader, die mit beliebigen Modellen gefüllt werden können. Verändert man den unsichtbaren Quader, so wird

das eingeschobene Modell entsprechend deformiert, um sich der neuen Form des Quaders anzupassen.

Das Schöne daran ist, daß das Modell selbst nicht unwiederbringlich verformt wird. Löst man nämlich die Verknüpfung von FFD und Modell, so

erscheint das Modell wieder unverändert. Dies gilt ebenso für Bones. Man kann also die verrücktesten Posen mit den FFDs realisieren. Sobald

man die FFDs vom Modell löst, erscheint das Modell wieder so, wie es modelliert wurde. Ein weiterer Vorteil ist, daß man die mit FFDs oder mit

Bones deformierten Modelle oftmals als neue Modelle abspeichern kann. So kann man praktisch mit dieser Technik auch modellieren.

Ein Beispiel: Man hat einen stehenden Mann modelliert, benötigen jedoch für ein Projekt einen sitzenden Mann. Nun wird man sich nicht die Mühe

machen, ein völlig neues Modell zu bauen. Statt dessen ist es sinnvoller, den stehenden Mann mit Bones "in die Knie zu zwingen" und ihn danach

als neues Modell unter anderem Namen abzuspeichern.

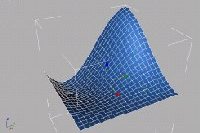

Veränderungsbeispiele mit FFDs

Um die besagten Quader zu manipulieren, stehen wieder zahlreiche Möglichkeiten zur Verfügung. Da wären z.b. das Taper-, das Scale-, das Twist-,

das Bend- und das Bezier-Werkzeug, um nur die wichtigsten zu nennen. Diese unterscheiden sich natürlich von Programm zu Programm in der

Namensgebung. Unterstützt die Software jedoch FFDs, was eigentlich alle tun, so werden diese oder ähnliche Funktionen ebenfalls dabei sein.

Wie üblich sind die Begriffe dem Englischen entnommen und stehen hier für Verjüngen, Skalieren, Verdrehen, Biegen und für Deformationen entlang

eines Bezier-Splines. All diese Manipulationen können jeweils auf eine oder mehrere Achsen des Quaders beschränkt werden und sind beliebig

kombinierbar. Oftmals lassen sich die FFD5 zudem z.b. über Morphing animieren und werden so zu einem unverzichtbaren Werkzeug 3D-Künstler.

Man denke da nur an die Cartoon-Geschöpfe, die sich beim Aufschlagen auf dem Boden entsprechend verformen.

Zusammenfassung Modellierung

Das sollte es erst mal für die Erstellung der Modelle gewesen sein. Die o.g. Werkzeuge und Funktionen bilden natürlich nur kleinen Abriss der

Möglichkeiten die heutige 3D-Software mit sich bringt. Über die gesamte Funktionalität der einzelnen Software wurden schon viele Bücher geschrieben

und allein die Erwähnung der gesamten Möglichkeiten würde den Rahmen dieses Seminars sprengen. Jedem der sich für spezielle Software, oder bestimmte

Modellierungstools interessiert, sei hiermit die Fachliteratur empfohlen.

Texturen und Oberflächen

Texturen

Um ein Bild auf einen Körper zu legen, stehen verschiedene Methoden zur Auswahl:

Die erste Technik ist das planare Mapping, auch FIächen-Mapping genannt. Dabei wird das Bild wie ein Dia, das auf einen Gegenstand geworfen wird, auf

ein Modell projiziert. Ist das Modell größtenteils parallel zum projizierten Bild, so funktioniert dies auch einwandfrei. Wie auf einer Leinwand wird

das Motiv unverzerrt erscheinen. Ist das Objekt jedoch gebogen und verwinkelt, so werden die Bilddaten in die nicht «einsehbaren» Nischen und um

Ecken herum gedehnt. Das ursprüngliche Bild wird verzerrt und dadurch im Regelfall unansehnlich. Um dies zu vermeiden stehen noch weitere Projektionsmethoden

zur Auswahl.

-

Eine davon ist das sphärische Mapping. Die Bilddaten werden dabei zu einer Kugel verbogen und dann auf das Objekt gelegt. Um hierbei Verzerrungen zu

vermeiden, sollte das Bild vorher in Polarkoordinaten umgerechnet werden. Eine typische Anwendung wäre z.b. eine Weltkarte, die auf eine Kugel projiziert

wird.

- Ähnlich funktioniert das zylindrische Mapping, bei dem das Bild quasi zu einer Rolle geformt wird, die unser Modell wie eine Röhre umschließt.

- Die letzte gängige Projektionsart ist das kubische Mapping. Dabei wird das Bild jeweils von oben, unten, rechts, links, vorn und hinten auf das Modell

gemappt. Hier können die gleichen Verzerrungsprobleme wie bei den bisherigen Mappingarten auftreten, wenn die Form des 3D-Objekts zu sehr von der

Mapping-Methode abweicht.

- Da aber nur ein Bruchteil aller 3D-Körper flach, kugelförmig, zylindrisch oder in Würfelform vorliegt, hat man eine neue MappingMethode entwickelt: das

uvw-Mapping. Dabei wird das aufzumappende Bild wie eine Gummihaut über das 3D-Modell gespannt, jeder Punkt des Modells bekommt eine Koordinate zugewiesen,

an die er sich klammert. Das Bild wird so auch in Bereiche «hineingezogen», die mit den anderen Methoden nicht zu erreichen wären, oder wo es zu

Verzerrungen kommen würde. Der Nachteil ist natürlich, daß das zu mappende Bild relativ schwierig zu erstellen ist, da es praktisch verzerrt erzeugt

werden muß, um die entsprechenden Farbwerte an die richtigen Stellen auf dem Objekt zu bekommen. Mit etwas Geschick lassen sich jedoch die gleichen

Resultate mit den oben erwähnten konventionellen Mapping-Methoden erreichen.

Mappingarten: kubisch, sphärisch, zylindrisch

Übrigens ist allen Methoden gemein, daß die Bilddaten frei auf dem Objekt verschoben werden können. Sie können nach Belieben skaliert und rotiert werden.

Bilder, die kleiner als der Körper sind, den sie bedecken sollen, können mosaikartig oder gespiegelt so oft wiederholt werden, bis der gesamte Körper bedeckt

ist.

Ebenso kann man durch den Gebrauch einer AlphaMaske nur einen Teil des 3D-Objekts mit dem Bild belegen Sie können ebenso bestimmen, ob die Textur ein

Objekt vollständig einfärben soll, oder ob die Textur nur bis zu einem bestimmten Anteil durchdringen soll.

Oberflächen

Zu den wichtigsten Oberflächeneigenschaften zählen:

- Ambient-Map

- Glanz Effekte

- Spiegelungs Effekte

- Transparenz Effekte

- Oberflächenstruktureffekte

Ambient-Map

Ambientes Licht ist Licht, das quasi überall ist. Es geht nicht von einer bestimmten Lichtquelle aus, hat also keine bestimmte Einfallsrichtung und wirft

keine Schatten. Es hellt schlichtweg alle Bereiche jedes Objekts gleichermaßen auf, egal ob schon eine Lichtquelle einen Bereich perfekt ausleuchtet oder nicht.

Ambientes Licht hellt z.b. auch Schatten auf, die somit nicht mehr 100% deckend schwarz sind. Dies läßt sich ebenfalls in der Natur beobachten. Einen 100%

schwarzen Schatten gibt es dort nicht. 3D-Programmen wäre er dagegen ohne weiteres berechenbar. Doch selbst wenn man jetzt den Wert für die Reflektion

ambienten Lichts nahe 1 .0 einstellen würden, würde sich an dem berechneten Bild noch nichts verändern da wir bis jetzt noch keine ambiente Lichtquelle

gesetzt haben. Denn wenn keine ambiente Lichtquelle in der Szene festgelegt ist, bleiben natürlich die Einstellungen im Ambient-Fenster ohne Wirkung. Wie

bei anderen Texturen können auch hier wieder Graustufenbilder eingesetzt werden.

Die Diffuse-Map ist ein Graustufenbild mit dessen Hilfe die Einstellung der Lichtwerte

vorgenommen werden kann. So können Gegenstände auch ohne Lichtquellen und Schattenberechnung "aufgemalte" Schatten besitzen. Dieses Verfahren wurde üblicherweise

nur verwendet um Schatten von nicht sichtbaren Objekten vorzutäuschen.

Specularity, Glanz Effekte

Hier werden die Glanzeigenschaften der Oberfläche beeinflußt. Es sollte aber klar sein, daß dies noch nichts mit Spiegeleffekten zu tun hat. Diese werden

in den ReflectivityBereichen eingestellt. Die Specularity steuert u.a. die Größe und die Farbe eines Lichtpunktes auf der Oberfläche. Matte Oberflächen,

die vielleicht noch aufgeraut sind werden keinen Lichtpunkt zeigen.

Meist sind noch weitere Regler vorhanden die den Glanz steuern der gerade noch unterhalb der Intensität eines Lichtpunktes liegt. Ähnlich wie beim Diffuse-Wert

kann hier auch der Übergangsbereich zwischen glänzenden und stumpfen Flächen ausgeweitet oder verjüngt werden. Zusätzlich kann man einen Farbwert bestimmen, den

der Lichtpunkt auf der Oberfläche annehmen soll, unabhängig von der Farbe der Lichtquelle.

Die «Diffuse Bias»Einstellungen zwingen den Renderer hingegen dazu, die Lichtflecken und glänzenden Flächen in der Farbgebung der Oberflächenfarbe anzupassen.

Diese Funktion läßt das Objekt realistischer erscheinen. Auch hier gibt es wieder die Möglichkeit ein Graustufenbild (Alpha-Maske) zu laden, um glänzende Bereiche

pixelgenau zu definieren.

Glanzeffekte ohne und mit Textur

Reflectivity-Map

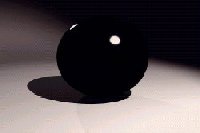

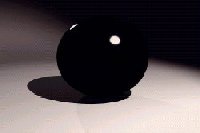

In den Reflectivity Einstellungen kann man die spiegelnden Eigenschaften der Oberfläche verändern. Man könnte einen Ball also so berechnen lassen, als wäre er aus

poliertem Stahl gefertigt, und die gesamte Umgebung würde sich in ihm spiegeln. Es können auch Bilddaten verwendet werden, die als Spiegelung dienen sollen. Dies hat

den Vorteil, daß nicht jeder Gegenstand, der sich auf dem Objekt spiegeln soll, auch wirklich modelliert werden muß. So kann z.b. ein Wolkenbild geladen werden, das

sich dann auf einer Wasserfläche spiegelt ohne daß der Himmel tatsächlich in der Szene existiert. Es kann die Stärke der Reflexion eingestellt werden. Ein Glas

reflektiert schließlich weniger stark als z.b. ein Spiegel. Andere Einstellungen kontrollieren das Verhalten einer Reflexion in den äußeren Bereichen eines abgerundeten

Körpers wie z.b. eines Weinglases. So lassen sich die Farbwerte der reflektierenden Objekte ändern oder dämpfen. Sogar die Randbereiche lassen sich gesondert definieren.

Natürlich kann man auch das Reflexionsverhalten durch Graustufenbilder variieren und so zum Teil verschmutzte Flächen darstellen.

Spiegelungen an Materialien

Transparency-Map

In den Transparency-Einstellungen, kann die Lichtdurchlässigkeit der Oberfläche eingestellt werden. Je mehr Licht durch die Oberfläche dringt, desto weniger kann

reflektiert werden, desto unsichtbarer wird das Objekt für den Betrachter. Einzig zwei Phänomene können den transparenten Körper verraten: Zum einen können trotz der

Transparenz Lichtpunkte und Reflexionen sichtbar werden, zum anderen kann der Körper das Licht brechen. Diese Eigenschaft lichtdurchlässiger Materialien nennt man Refraktion.

Dabei können Objekte, die hinter einem transparenten Objekt mit Refraktion liegen, plötzlich verzerrt erscheinen. Je größer der Refraktionswert, desto stärker wird das

Licht im Objekt umgelenkt und desto stärker treten somit Verzerrungen auf.

Ein Wert von 1 .0 bedeutet, daß das Licht ungebrochen den Körper passiert, sofern dieser transparent ist. So hat z.b. Wasser einen Wert von 1.333, Eis den Wert 1 .305 und

Glas den Refraktionswert 1 .5. Entsprechende Werte, die in der Natur vorkommen, können guten Physikbüchern entnommen werden.

Bei den Transparenz-Eigenschaften können ähnlich den Einstellungen für die Spiegelungswerte die Ecken eines Körpers noch genauer definiert werden. Die Transparenz eines

Körpers nimmt zu den Ecken hin ab, verhält sich also genau entgegengesetzt zu den Reflexionseigenschaften. Auch hier können wieder Graustufenbilder genutzt werden.

Ähnlich den Transparency Maps gibt es die Clipping-Maps. Mit ihnen ist es Möglich, Teile eines Modells auszuschneiden. An den entsprechenden Stellen kann man also durch

das Modell hindurchschauen, wie wenn dort ein Loch modelliert worden wäre. Schattenwurf des Modells wird davon ebenfalls beeinflußt, so daß die Illusion perfekt wird. Die

Benutzung geht wie mittlerweile gewohnt über Graustufenbilder vonstatten. Schwarze Flächen werden ausgeblendet, weiße bleiben erhalten. Diese Methode hat gegenüber den

Transparency-Maps den Vorteil, daß Lichtpunkte automatisch unterbleiben und, daß die Lochränder abgerundet werden. So können sehr schnell Lochblenden oder Gitter dargestellt

werden.

Transparency-Map

Refraktionen und Caustics unter einer Glasscheibe

Beispiel: Ring

Oberflächenverändernde Maps

Es gibt 2 Arten von Oberflächenverändernden Maps, die Bump Maps, die die Oberflächenveränderung nur vortäuschen, und die Displacement Maps.

Bump-Maps:

Um die Arbeitsweise der Bump-Maps zu verstehen, ist ein kurzer Exkurs in Berechnung einer schattierten Oberfläche nötig. Die Information, wie ein Polygon zu einer Lichtquelle

liegt, kann die Software mittels der Normalenvektoren berechnen. Alle Normalenvektoren haben die Eigenschaft, daß sie genau senkrecht auf der zugehörigen Fläche stehen. Anhand

der Stellung der Normalvektoren zur Lichtquelle, werden die Lichtpunkte und Beleuchtungen berechnet.

Die oben erwähnten Bump-Maps sind nun in der Lage, diese Vektoren lokal zu verbiegen. Sie zeigen dann also in eine andere Richtung, als die Fläche unter ihnen dies vorgibt.

Der Software wird damit vorgetäuscht, an dieser Stelle gäbe es eine Senke oder eine Steigung, obwohl dort keine ist. Entscheidend ist, daß im Ergebnis an entsprechenden Stellen

tatsächlich Erhebungen und Senken zu sehen sind, obwohl sie gar nicht modelliert wurden. So lassen sich sehr feine Furchen, Rillen, Falten und andere Strukturen realistisch

darstellen, die man nicht mehr ausmodellieren muß. Bump-Maps sind Graustufenbilder, wobei ein hoher Helligkeitswertwert eine Steigung und ein niedriger Wert eine Senkung

simulieren. Wichtig ist, daß die tatsächlichen Modellflächen unverändert bleiben. Nur die Schattierung der Flächen wird geändert. Dies macht sich leider besonders an der Silhouette

eines Modells bemerkbar: Wenn z.b. eine durch Bump-Mapping simulierte tiefe Furche über eine Kugel läuft, wird sie an deren Rändern nicht zu sehen sein. Bump-Maps wirken also

nur dann realistisch, wenn der Sichtwinkel nahezu senkrecht ist und die Bump-Maps nicht die Randgebiete eines Modells beeinflussen. Die Stärke des Effekts kann zudem noch durch

Zahleneingabe beeinflußt werden. Je höher der Wert desto stärker die Höhen und Tiefen.

Bump-Maps können die Fotorealistik entscheidend erhöhen, müssen jedoch vorsichtig eingesetzt werden. Ebenso sollten die Stärke-Werte in Vernünftigen Werten gehalten werden, da

der Effekt sonst schnell ins Gegenteil umschlägt und unrealistisch ist.

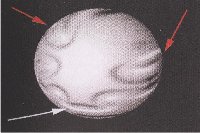

Vertiefungen mittels Bump-Maps

Displacement-Maps:

Die Displacement Maps arbeiten ähnlich wie Bump-Maps, nur daß bei ihnen die Normalenvektoren eher indirekt verändert werden. Displacement-Maps ändern tatsächlich die Form des

Körpers. Die Stellen, die unter hellen Bereichen des Graustufenbildes zu liegen kommen, werden nach außen verschoben. Dunkle Bereiche bewirken eine Absenkung der Modell-Polygone.

Dies funktioniert jedoch nur, wenn das Modell tatsächlich sehr fein in Polygonen aufgelöst ist, denn es können nur dort Oberflächenwerte geändert werden, wo auch Eckpunkte

liegen. Daher bieten die meisten 3D-Programme auch die Option an, die Modelle wahlweise feiner zu unterteilen.

Displacement Maps werden also eingesetzt um Objekten wirklich eine detailliertere Struktur zu geben. Dies kann sinnvoll sein, wenn Bump-Maps wegen ihrem Graden Schattenwurf störend

auffallen würden. In Anwendungen, in denen nicht Fotorealismus das Ziel ist, wird in der Regel Bump-Mapping verwendet um Performance einzusparen.

Vertiefungen mittels Displacement-Maps

Licht

Um eine Scene wirklich realistisch erscheinen zu lassen, muss ein grosses Augenmerk auf die richtige Ausleuchtung gelegt werden. Wie bei sich ein professionelles Foto mit guten

Lichtverhältnissen von einem Amateurfoto abhebt, hebt sich auch eine gut ausgeleuchtete Scene von einer Scnene ab die nur leihenhaft mit Licht bearbeitet wurde. Wirklich gutes Licht

zeichnet sich dadurch aus, daß es nicht bewusst wahrgenommen wird, sondern als natürliches Element des Bildes "untergeht". Genau dies zu erreichen ist eine der bedeutensten

Aufgabenstellungen bei der Erstellung künstlicher Bilder.

Lichtquellen

Jede Software beinhaltet einige Standardlichtquellen:

- Radial strahlende Lichtquelle

- Spot Lichtquelle

- Paralleles Licht

Lichtarten: Radial, Spot und Parallel

Radial strahlende Lichtquelle

Hierbei handelt es sich um sie Standardlichtquelle schlechthin. Jede Lichtquelle die in eine Scene eingefügt wird ist zu ersteinmal eine radiale Lichtquelle.

Bei der radial abstrahlenden Lichtquelle handelt es sich um eine Lichtquelle, die das Licht in alle Richtungen gleichmässig abgibt, ähnlich einer Glühbirne oder einer Kerzenflamme. Wie bei

anderen Lichtquellen kann die Helligkeit und die Lichtfarbe bestimmt werden. Auch ist es möglich, die Leuchtweite zu regulieren. So kann z.b. anhand eines Kugelförmigen Bereiches festgelegt

werden, wie weit das Licht die Scene erhellt. Auch kann ein Bereich festgelegt werden in dem die Lichtquelle mit gleichbleibender Helligkeit strahlt, von dem dann bis zur max. Leuchtweite

die Helligkeit stetig abnimmt.

Radiale Lichtquelle

Spot Lichtquelle

Ein Spot ist dem radialen Licht sehr ähnlich, nur daß hier das Licht gezielt in eine Richtung und im Abstrahlwinkel begrenzbar abgegeben wird. Zusätzlich zur Reichweite kann hier auch ein

sogenannter innerer und ein äußerer Kegel festgelegt werden. In diesen Kegeln passiert genau das gleiche wie in den gedachten Um-Kugeln der radialen Lichtquelle. Die Lichtleistung nimmt

zwischen äusserem und inneren Kegelböden und zwischen den Kegelwänden zu Null ab.

Zum Hervorheben eines bestimmten Objektes eignet sich ein Spot. Es ist möglich mit einer Art "point_at" Befehl ein Objekt anzugeben, das der Spot anstrahlen soll, was die Handhabung sehr

komfortabel erscheinen lässt.

Spot Lichtquelle

Paralleles Licht

Für viele Beleuchtungsaufgaben wäre es sinnvoll, keine punktförmige Lichtquelle zu haben, da bei radialen und Spot-Lichtquellen die Lichtstrahlen ja grösstenteils in einem Winkel auf dem

Objekt eintreffen. Dies kann durchaus stören, wenn der Schattenwurf eine Rolle spielt. Durch punktförmige Lichtquellen beliebiger Art entstehen natürlich entsprechend verzerrte Schatten,

die z.b. bei Beleuchtung durch die Sonne so nicht auftreten würden. Eine Lösung dieses Problems wäre, die Lichtquelle sehr weit vom Objekt zu entfernen, damit für einen kleinen Bereich die

Lichtstrahlen nahezu parallel eintreffen. Dieses Vorgehen ist allerdings ziemlich umständlich. Deswegen hat man die parallel abstrahlenden Lichtquellen eingeführt. Sie wirken wie eine Ebene,

aus der senkrecht Licht austritt. Die Lage der Ebene und damit der Einfallswinkel

des Lichtes kann ebenso gesteuert werden wie die Intensität und Reichweite. Tatsächlich verwenden einige Programme für die interne Berechnung eine normale radiale

Lichtquelle, die unendlich weit entfernt ist. Der Benutzer braucht jedoch nicht in die Weiten der 3D-Fenster hinauszuzoomen, um eine entsprechende Lichtquelle zu setzen,

sondern er kann das Parallel-Licht in unmittelbarer Nähe zu seinen Modellen positionieren. Die Software rechnet die Lage des Lichtes entsprechend um. Die parallele

Lichtquelle hat aber auch Nachteile denn nicht jede Software unterstützt paralleles Licht in Verbindung mit weichen Schatten. Das bedeutet die Schattenränder sind

scharf abgegrenzt und haben keine Verläufe.

Weitere Lichtquellen

Die gängige 3D-Software unterstützt noch viele weitere Lichtquellen die aber meistens nur Erweiterungen zu den Standardlichtquellen implementieren. So gibt es die Möglichkeit eine Röhrenlichtquelle

zu benutzen die das licht über eine bestimmte Länge abgibt. Auch gibt es vielmals die Möglichkeit eine Lichtquelle als Fläche zu definieren.

Bei all den oben genannten Lichtquellen gibt es eine weitere recht interessante Eigenart. Für alle Lichtquellen kann man eine Farbe festlegen, mit der dann die Objekte erhellt werden. Es gibt

aber auch die Möglichkeit Lichtquellen die Farbe Schwarz zuzuweisen. Das führt nicht dazu das eine Lichtquelle nicht leuchtet, sonder führt vielmehr dazu das die Lichtquelle der Umgebung Licht

absaugt und somit die Umgebung sogar abdunkelt.

Sichtbare Lichtquellen

Lichtquellen in 3D-Software unsichtbar. So lassen sich Lichtquellen auch direkt vor der Kamera plazieren ohne das dies später zu sehen sein wird. Das bringt grosse Vorteile mit sich, die sicher

auch von Fotografen gern genutzt werden würden. Im Gegenzug aber gibt es Probleme Lichtquellen sichtbar zu machen. So kann ein Objekt zwar eine helle Farbe annehmen, so daß es den Anschein hat

es würde leuchten, doch absolut unverkennbar für Lichtquellen sind die Lens Flares. Vor einigen Jahren noch der letzte Schrei im 3D-Bereich, beherrscht heute selbst das günstigste Programm Lens Flares.

Lens Flares sind Strukturen, die entstehen, wenn Licht durch Linsen fällt. Da die Linsen nie ganz perfekt geschliffen sind, wird das Licht teilweise gebrochen und wie bei einem Prisma in verschiedene

Farben aufgeteilt. So ergeben sich kreisförmige oder auch eckige Strukturen, die teilweise oder über die gesamte Linse verteilt sind, und kranzförmige Lichterscheinungen, die sich um die Lichtquelle herum bilden.

So schön der Effekt auch anzusehen ist so ist er heute nicht mehr aktuell und Profi-Anwender meiden diesen Effekt inzwischen.

Sinnvoll läßt sich dieser Effekt eigentlich nur noch bei exotischen Lichtverhältnissen einsetzen, wie z.b. glühenden Austrittsgasen eines Raumschiffes. Fakt ist, daß dieser Effekt nicht auftritt,

wenn etwas mit bloßem Auge betrachtet wird. Erst künstliche Linsen aus Glas oder Kunststoff rufen diesen Schmutzeffekt» hervor. Um den Realismus zu erhöhen sollten Lens Flares nur in geringem ausmass

verwendet werden, oder man sollte sogar ganz darauf verzichten.

Einige Lensflare Effekte

Wo Licht ist, ist auch Schatten!

Jedes Objekt in der Natur wirft einen Schatten, doch diesen Schatten im Computer realistisch nachzubilden ist ein sehr rechenintensiver Vorgange. Um die benötigte Rechenleistung nicht zu sehr zu steigern

verwendetet man Shadow-Maps, die bei vertretbarem Rechenaufwand gute Ergebnisse liefern. Natürlich kann man Schatten auch physikalisch korrekt mittels eines Ray-Tracers berechnen lassen.

Weicher Schatten der Shadow-Map

Bei den Shadow Maps (Schatten-Maps) handelt es sich um Bilder, die beim ersten Durchgang des Renderns berechnet werden. Die erzeugten Bitmaps werden dann von der Lichtquelle aus projiziert. Shadow Maps

nehmen zum Beispiel nicht die Farbe an, die von transparenten oder durchscheinenden Objekten geworfen wird. Im Gegensatz zu Raytrace-Schatten können Schatten-Maps jedoch weiche Schattenränder erzeugen.

Harter Schatten des Raytracers

Raytrace Shadows generiert der Renderer, indem er den Pfad der Lichtstrahlen nachzeichnet. Raytrace-Schatten sind genauer als Schatten-Maps. Sie führen immer zu scharfen Rändern, die je nach dem gewünschten

Effekt von Vor- oder Nachteil sein können. Schatten von transparenten und halbtransparenten Objekten werden genauer berechnet als bei Shadow Maps. Das Raytracing-Verfahren benötigt aber auch mehr Rechenleistung,

weil ja alle von einer Lichtquelle ausgehenden Strahlen verfolgt werden müssen. Zusätzlich müssen auch die Transparenzen mit den Refraktionen berechnet und berücksichtigt werden. Dies stellt die meisten

3D-Programme vor eine unlösbare Aufgabe was dann zu teilweise merkwürdigen Dialogen führt, in denen z.b. die Eingabe einer Schattenfarbe für durchsichtige Gegenstände gefordert wird. Auch müssen Objekte aus einem

bestimmten Raytrace-Material bestehen um eine korrekte Berechnung zu ermöglichen.

Um die Berechnung von vielen kleinen Teilchen, wie Nebel, zu simulieren, kann man Volumenlicht verwenden.

Volumenlicht, das Bild wird durch Volumenlicht deutlich aufgewertet

Rendern

Die Darstellung von Objekten in einer Scene wird vom Renderer Vorgenommen. "Rendern" ist ein Verfahren zur Erzeugung einer Darstellung von einem 3D-Modell am Bildschirm oder zur Ausgabe auf einem Plotter/ Drucker,

das realistischer erscheint als ein Drahtmodellbild. Dabei werden die Flächen des CAD-Modells mit einer Oberflächenstruktur versehen. Beim Rendern gibt es mehrere RenderOptionen die dramatische Auswirkungen

auf das Ergebnis haben.

Wenn man in der Computergrafik von Photorealismus redet, ist das Licht ein entscheidender Faktor. Das natürliche Verhalten von Licht nachzuahmen gehört aber gleichzeitig zu den

schwierigsten Aufgaben. Es gibt zwar schon Rendering-Verfahren wie Radiosity, Global Illumination oder Radiance, die den Strahlenverlauf des natürlichen Lichts nachbilden, allerdings

sind durch die komplexen Berechnungsaufgaben selbst heutige Computersysteme noch vielfach überlastet. Rechenzeiten von bis zu mehreren Stunden und mehr pro Bild sind keine Seltenheit

und machen diese Verfahren im Moment noch nicht für bewegte Bilder rentabel. Aus diesem Grund müssen durch Tricks Wege gefunden werden, diese Rechenzeiten zu verkürzen.

Die wichtigsten Darstellungsformen / Rendermodi:

- Wireframe

- Flat-Shading

- Gouraud-Shading

- Phong-Shading

- Raytracing

- Radiosity

Wireframe

Wireframe wird hauptsächlich in den 3 Ansichtfenstern der 3D-Programme verwendet und ist die niedrigste und schnellste Stufe beim Rendern. Dabei werden nur Polygonlinien als sichtbare Linien gezeichnet. Deren Stärke

kann im Rendermenü beeinflusst werden. So kann man je nach Bedürfnis zwischen Haarlinien und mehrere Pixel starken Linien wählen. Eine nahe Verwandte des Wireframe ist die Hidden-Line-Darstellung. Hier werden alle

verdeckten Polygone ausgeblendet, so daß die Modelle an sich besser erkennbar werden als mit Wireframe. Je nach verwendeter Software kann man bereits erkennen wie die Objekte beleuchtet sind.

Flat-Shading

Die nächst höhere Stufe, nach dem Wireframe, ist das Flat-Shading. Die Polygonflächen werden mit der Grundfarbe des Modells gefüllt. eine Schattierung der Polygone findet nicht statt. Jedes Polygon erhält also nur

einen Farbwert, der sich aus der mittleren Helligkeit der Fläche ergibt. Die durch die Lichtquelle hervorgerufenen Effekte auf der Oberfläche des Modells lassen sich so nur grob erahnen, aber man kann sich schon einen

Eindruck von einer Scene machen. Texturen und Oberflächen werden nicht berücksichtigt.

Diese Berechnungsmethode steht oftmals sogar in den Ansichtsfenstern zur Verfügung, um schon bei der Modellierung einen Besseren Überblick zu bekommen.

Gouraud-Shading

Die heute am weitesten verbreitete Methode zur Schattierung von Polygonen ist das Gouraud-Shading, respektive Intensity Interpolation Shading, Color Interpolation Shading oder auch Vertex Lighting. Das Gouraud-Shading

ist eigentlich nur eine allgemeine Version des Interpolated Shading für beliebige Polygone. Im Gegensatz zum Flat-Shading, bei dem man einen einzigen Intensitätswert für das gesamte Polygon heranzieht, werden beim

Gouraud-Shading die Farbwerte an jedem Eckpunkt ( Vertex) berechnet. Anschließend interpoliert das Verfahren linear diese Werte über die Kanten des Polygons und über jede Scanline, um so das Polygon zu schattieren.

Durch Gouraud-Shading entstehen realistische Farbverläufe und eine Kantenglättung wird berechnet. Somit lassen sich komplexe Körper und vor allem gekrümmte Oberflächen besser und mit deutlich weniger Polygonen darstellen

als beim Flat-Shading.

Es entstehen jedoch Probleme, wenn Gouraud-schattierte Bilder Glanzlichter erhalten sollen. Diese werden entweder undeutlich, verwaschen oder als Stern-Artefakt gezeigt, das heißt, die Reflektion ist nicht rund, sondern

sternförmig.

Phong-Shading

Das Phong-Shading ist ein rechenintensives Verfahren zur Schattierung von Polygonen und ist deshalb erst heute in Echtzeitanwendung zu finden, wird aber von 3D-Software unterstützt. Die Grundidee des Verfahrens ist folgende:

- berechne an jedem Eckpunkt den Normalenvektor des Vertex

- interpoliere die Normalenvektoren über die Kanten zwischen den Eckpunkten

- interpoliere die Normalenvektoren über die Scanlines zwischen den Kanten

- berechne die genaue Farbe eines jeden Pixel mit Hilfe des Skalarproduktes zwischen dem interpolierten Normalenvektor und dem Vektor des Lichts

Das ist ähnlich wie beim Gouraud-Shading, bei dem die Farben und Intensitäten linear interpoliert werden. Phong-Shading ist ein Per-Pixel-Verfahren. Das heißt, der Prozessor berechnet die Beleuchtung für jeden Pixel einzeln,

was den immensen Rechenaufwand verdeutlicht. Dafür kommt das Phong-Shading gut mit Reflektionen und Glanzlichtern zurecht, was beim Verfahren von Gouraud nur unzureichend möglich ist. Auch das vom Flat-Shading bekannte Kantenbilden,

das beim Gouraud-Shading bereits gemindert ist, wird noch weiter verringert.

Phong-Shading darf nicht mit dem Phong-Lighting verwechselt werden. Manche Marketingabteilungen brüsten sich gerne damit, dass ihre Applikationen das Phong-Shading-Beleuchtungsmodell verwenden. Sie benutzen aber nur

das Phong-Lighting-Verfahren, das an jedem Eckpunkt den entsprechenden Lichtwert berechnet. Die tatsächliche Schattierung findet dann nur mit normalem Gouraud-Shading statt.

Raytracing

Beim Raytracer werden alle Normalvektoren eines Modells neu aufgebaut, verfolgt dann jedoch das Licht von der Quelle bis zum Objekt. Mit diesem Verfahren lassen sich alle Funktionen der Texturen und Oberflächenwerte in des Endbild einrechnen.

Dieses Verfahren dauert jedoch länger als Phong-Shading. Kann auf Refraktionen und Spiegelungen verzichtet werden, kann man mit Phong-Shading ähnliche Resultate erzielen.

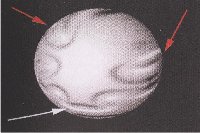

Radiosity

Radiosity ist ein Lichtberechnungsverfahren, das der Realität sehr nahe kommt. Es betrachtet Licht nicht als einen Strahl, der nach dem Auftreffen auf einer Fläche endet. Radiosity berechnet das reflektierte Licht

unter Berücksichtigung von Material- und Reflexionseigenschaften und Ein- und Ausfallswinkel. Es berechnet also eine korrekte diffuse Beleuchtung. Im Zusammenhang mit der Berechnung von diffusen Lichtreflexionen

wird auch der Begriff "Global Illumination" genannt. Dieses Verfahren führt nahezu zu gleichen Ergebnissen, ist schneller in der Berechnung, aber nicht ganz so genau, jedoch für Animationen völlig ausreichend.

Der bekannteste Vertreter dieser Gattung ist MentalRay.

Liegt in einem mit Radiosity berechneten Bild ein farbiger Gegenstand vor einem anderen Objekt so wird sich das 2. Objekt leicht verfärben, auch wenn das Objekt keine Reflektion hat. Befinden sich mehrere verschiedenfarbige

Objekte in einer Szene, die auch noch von mehreren verschiedenfarbigen Lichtquellen angeleuchtet werden, so kann man sich vielleicht vorstellen, wie aufwendig diese Rechenmethode sein kann. Sie wird daher zumeist nur bei

Standbildern eingesetzt. Hinzu kommt, daß das Radiosity-Verfahren längst noch nicht in allen Programmen zur Verfügung steht. Oftmals sind teure Mehrausgaben nötig, da dieser Render-Zusatz separat verkauft wird. Sieht man

zwei gleiche Szenen einmal mit und einmal ohne Radiosity nebeneinander, kann man jedoch die Vorteile dieses Verfahrens nicht mehr verleugnen. Der Gesamteindruck ist wärmer und natürlicher.

Radiosity: Rötlicher Bereich am Hintergrund

Beleuchtungseffekte mit Radiosity

Alpha-Maske

In jeder der genannten Berechnungsmethoden ist das Erstellen einer sogenannten Alpha-Maske möglich.

3D-Programme berechnen also nicht nur das eigentliche Bild, sondern auf Wunsch gleichzeitig auch eine sogenannte Alpha-Maske, die die spätere Nacbbearbeitung in 2D-Programmen entscheidend vereinfachen kann. Eine Alpha-Maske

ist ein Graustufenbild, wobei weiße Bereiche dort eingezeichnet werden, wo Objektdaten berechnet wurden. Schwarze Stellen stehen für den Hintergrund. In einem 2D-Bildbearbeitungsprogramm können diese Bereiche nun in eine Auswahl

geladen werden. Wendet man diese Auswahl dann auf das berechnete Bild an, so kann man das Motiv nahtlos in andere Bilder integrieren. Mit Hilfe dieser Masken kann man in einem Bildbearbeitungsprogramm z.b. Körper einfacher

freistellen und mit anderen Bildern kombinieren. Zusätzlich zur Alpha-Maske kann noch ein weiteres Graustufenbild berechnet werden, welches Informationen über die Lage des Objektes im Raum enthält.

Erstellung einer Tiefenschärfe-Alpha-Maske

Animation

Animation in der Computergrafik bedeutet, Objekteigenschaften über einen Zeitraum zu verändern. Dabei müssen sich nicht nur Körper an sich bewegen, sondern es können sich auch die Formen und Eigenschaften der Körper verändern.

Die Illusion wird erst perfekt, wenn die Scene zum Leben erwacht, wenn sich die Flächen, die Texturen, die Beleuchtung und die Perspektive ändern. Erst wenn der Betrachter auch hinter die Objekte sehen kann, kommen die Stärken von

3D richtig zur Geltung

Wie der Animationsteil der einzelnen Software ausfällt ist sehr Unterschiedlich, manche bieten sogar ein fast eigenständiges Programm zur Realisierung der Animationen an. Dennoch sind in allen Umsetzungen die wichtigsten Animationstechniken

umgesetzt.

Die wichtigsten Animationstechniken:

- Keyframes

- Kinematik

- Bone

- Kraftfelder

Keyframes

Jede Software die in irgendeiner Weise mit Animation zu tun hat unterstützt Keyframes. Dabei werden für jedes Element einer Scene alle Werte, wie Position, Rotation, Grösse, usw. , gespeichert. Dieses "Bild" mit festen Werten für alle

Objekte nennt man Keyframe. Um ein Keyframe zu erzeugen, legt man die Eigenschaften der Objekte zu einem Zeitpunkt fest. Das bedeutet, dass später in der Animation zu genau diesem Zeitpunkt das Bild so aussehen soll wie im Keyframe angegeben.

Da Keyframes einen eindeutigen Zeitwert besitzen wird die Software dafür sorgen, dass alle Elemente die über ein Keyframe verfügen, zu den angegebenen Zeitpunkten exakt die vorgegebenen Werte übernehmen werden. Zwischenschritte zwischen den Keyframes

werden automatisch berechnet, so dass ein sanfter Übergang zwischen zwei benachbarten Keyframes entsteht.

Mit dieser Methode kann ein Grossteil der Animationsprojekte verwirklicht werden. Die Keyframeanimation ist sehr leicht zu erlernen, und auch die Software ist intuitiv zu bedienen. Man kann jeder Zeit in die Zeitleiste springen und die Objekte nach

belieben manipulieren.

Die Bewegung zwischen den Keyframes muss nicht immer gradlinig verlaufen. Zu diesem Zweck gibt es Controler. Die Controller sind ein wichtiger Bestandteil des Animationskonzepts in vielen 3D-Programmen. Sie steuern nicht nur Bewegungen von

Objekten, sondern auch die Veränderung von Parametern aller Art. Die Animation kann je nach Controller zum Beispiel durch Platzieren von Keyframes, durch automatische Prozeduren oder durch mathematische Formeln erzeugt werden.

Die Controller lassen sich in sechs Gruppen untergliedern:

- Keypunkt-Controller:

Diese Controller sind die einfachste und weitverbreitetste Form der AnimationsController. Sie regeln das Verhalten von Objekten und Parametern zwischen Schlüsselbildern, den Keyframes. Die Bilder zwischen Keyframes werden auch Tweens genannt und durch

eben diese Controller gesteuert.

- Zusammengesetzte bzw. Listen-Controller:

Bei diesen Controllern handelt es sich um Kombinationen von Controllern. Sie ermöglichen zum Beispiel, bei Bewegungen jeder Bewegungsrichtung einen eigenen Controller zuzuordnen. Sie werden auch ListenController genannt.

- Prozedurale Controller:

Prozedurale Controller, auch parametrische Controller genannt, besitzen keine Schlüsselbilder. Sie regeln eine Animation, indem sie ein bestimmtes Verhalten definieren, das durch Parameter verändert werden kann. Sie können zum Beispiel Veränderungen

durch ein Rauschen oder eine oszillierende Kurve oder auch durch einen importierten Audiofile generieren.

- Abhängige Controller:

Controller dieses Typs erstellen Animationen, die in einem Bezug zu einem anderen Objekt stehen. Sie verändern das Objekt entweder abhängig von der Form, der Transformation oder des Verhaltens eines anderen Objekts. Zu dieser Gruppe zählen auch die

Constrain Controller. Sie ermöglichen es, Abhängigkeiten auch zu mehreren Objekten gleichzeitig zu definieren.

- Controller-Systeme:

Um komplexe zusammenhängende Animationssysteme zu schaffen, benötigt man Controller, die nicht nur Abhängigkeiten definieren, sondern auch das Verhalten durch Formeln oder Zeit steuern können. Zu diesen Controllern gehört zum Beispiel der Ausdruck

(Expression)-Controller. Mit ihm können Bewegungsabläufe über mathematische Definitionen angegeben werden, die auch von Bewegungen anderer Objekte abhängig sein können. So lassen sich zum Beispiel die Bahnen von Planeten in einem Sonnensystem oder

eine realistische Uhr mit animierten Zeigern erstellen.

- Sonder-Controller:

Dabei handelt es sich um Controller, die nur für bestimmte Dinge zuständig sind. So regelt der Baryzentric Morph Controller die Animation von Objektüberblendungen und der IK-Controller kann nur mit Bones verwendet werden. Der Block Controller fasst

Animationssequenzen zu Blöcken zusammen, die in der Zeitleiste angeordnet und gemischt werden können.

Verschiedene Controler bei 3DS Max

Forward und Inverse Kinematik

Die Forward und Inverse Kinematik wird dazu verwendet, Roboterarme oder Körper anhand von eingebundenen Skeletten zu verformen und zu animieren. Die Thematik der inversen Kinematik ist sehr komplex und würde den Rahmen dieser Ausarbeitung sprengen.

Allgemeine Definitionen der Inversen Kinematik:

Um mit Hilfe der Forward bzw. Inversen Kinematik Roboterarme oder ganze Körper zu bewegen, müssen zunächst einige Dinge festgelegt werden:

- Als Erstes müssen die Objekte miteinander verknüpft werden.

- Daraufhin werden die Gelenkmittelpunkte festgelegt und eventuelle Einschränkungen definiert.

- Jetzt können die Arme bewegt werden. Dies kann entweder mit Hilfe der Forward oder der Inversen Kinematik geschehen.

Kinematische Kette

Forward Kinematik (FK)

Bei der Verknüpfung von Objekten werden übergeordnete (Parent) und untergeordnete (Child) Objekte generiert. Ein Parent kann wiederum ein untergeordnetes Objekt sein, das einem Parent

zugeordnet wird. Die Forward Kinematik besagt, dass, wenn das übergeordnete Objekt (Parent) transformiert wird, alle Bewegungen, Drehungen oder Skalierungen auf den untergeordneten Körper (Child) übertragen werden.

Inverse Kinematik (IK)

Die Inverse Kinematik kehrt die Forward Kinematik um. Dabei wird das Child transformiert. Die Parents versuchen, gemäß ihren Parametern und der Objektdefinition der Transformation zu folgen. Bei der

Berechnung werden auch Gelenkattribute berücksichtigt um physikalisch falsche Stellungen zu verhindern

Beispiel Bewegung einer kinematischen Kette

Skelette mit Bones

Die Software erleichtert dem Benutzer das Erstellen von Kinematischen Ketten bzw. Skeletten durch so genannte Bones (Knochen). Das sind fertig verknüpfte, auf inverse Kinematik optimierte Hilfsobjekte, die bei der

Generierung bereits miteinander verknüpft sind. Diese Bones-Ketten, auch Skelette genannt, können in andere Objekte eingebunden werden. Das hat den Vorteil, dass die Objekte um die Kette herum austauschbar

werden bzw. das Skelett getrennt vom Objekt erstellt und animiert werden kann. Bones bieten aber einen unschlagbaren Vorteil: Es können mehrere Knochen in ein Objekt, zum Beispiel einen Arm, eingebunden

werden, das sich verformt, wenn die Knochen bewegt werden. Das Objekt, in das die Bones eingebunden wurden, dient sozusagen als Haut.

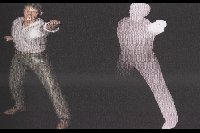

Verformung mit Bones

Grundsätzlich kann jedes Objekt als Bone fungieren. In manchen Programmen gibt es jedoch spezielle Objekte, die bereits fertig miteinander verknüpft sind. Ein Bones-Skelett wird zunächst ohne

Inverse-Kinematik-Kette aufgebaut. Das bedeutet, man muss einen IK Solver zuweisen oder kann mit Forward Kinematik arbeiten.

Verformung eines Zylinders mit Bones

Bein mit Bones

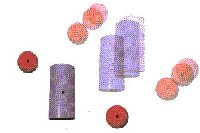

Partikelsysteme

Bei Partikelsystemen handelt es sich um Objekte, die aus einer Quelle kleine Objekte ausstoßen werden. Sie dienen zur Simulation von Rauch, Staub, Regen oder Schnee. Partikelsysteme können von Kraftfeldern

beeinflusst werden. Sie können durch die Schwerkraft, Wind oder durch Deflektoren abgelenkt werden.

Partikelsysteme stossen Klone des Ursprungskörpers aus.

Space Warps (Kraftfelder)

SpaceWarps sind Objekte, die sich auf das Erscheinungsbild anderer Objekte oder Partikelsysteme auswirken. Sie werden auch Kraftfelder genannt, da sie andere Objekte verformen und den Effekt von Wellen,

zentrischen Wellen, wehendem Wind, Schwerkraft oder eine Ablenkung von Partikeln verursachen. Die Kraftfelder werden in fünf Gruppen unterteilt.

- Forces (Kräfte):

Hier befinden sich die wichtigsten und auch am häufigsten benötigten Kraftfelder für Partikel- und dynamische Systeme.

- Deflectors (Deflektoren): Sie ermöglichen es, Partikelsysteme von Objekten abprallen zu lassen und Körper, die in ein dynamisches System eingebunden sind, in ihrer Position zu verschieben – wie ein

Wasserstrahl, der auf eine Box trifft und diese wegspült.

- Geometric/Deformable (Geometrisch/Verformbar):

Diese Space-Warps verformen die Geometrie eines Körpers. Daher können sie nur auf diese Objekte angewendet werden – mit einer Ausnahme. Das Displace (3D-Verschieben)-Kraftfeld kann auch Partikelsysteme

beeinflussen.

- Modifier Based (Auf Modifikator basierend):

Dabei handelt es sich um Kraftfelder, die auf Modifikatoren basieren. Sie bleiben eigenständige Objekte, die sich beispielsweise auch auf mehrere Objekte auswirken können. Die Position der einzelnen

Körper nimmt dabei Einfluss auf den Feld-Effekt.

- Particles & Dynamics (Partikel & Dynamik):

Diese Kraftfelder können sich auf Partikel auswirken. Auf geometrische Körper können sie nur mittels dynamischer Systeme angewendet werden.

Eine Kugel wird durch ein FFD Kraftfeld gedrückt.

Allgemeine Arbeitsweise von Kraftfeldern

SpaceWarps haben Ähnlichkeit mit Freiform Deformatoren. Ein SpaceWarp beeinflusst jedoch den Raum der Welt und nicht wie geometrische Modifikatoren den Objektraum. Wird ein Modifier auf ein Objekt angewendet

und anschließend der Körper verschoben, ändert sich der Effekt des Modifiers nicht, er behält seine Position zum Objekt bei – die Transformation wird erst nach der Berechnung aller Modifikationen angewendet.

Kraftfelder sind dagegen Objekte, die ihre eigene Position besitzen. Sie werden unabhängig von anderen Objekten transformiert. Verknüpft man einen Körper mit einem SpaceWarp, wird die Verknüpfung nach der

Transformation angewendet. Die Position, Drehung und Skalierung des SpaceWarps beeinflusst seinen Effekt und erzeugt unterschiedliche Ergebnisse bei Körpern. Es können auch mehrere Objekte an ein Kraftfeld

gebunden werden, während ein Modifier nur als Klon auf weitere Objekte übertragen werden kann.

Hilfsmittel zur Animationserstellung

Um Animationen zu erstellen, zu bearbeiten und zu regeln, stellt 3D Software einige Hilfsmittel zur Verfügung.

Der Schwerpunkt eines Objekts (Pivot-Punkt)

Der Schwerpunkt eines Objekts dient bei Animationen als Ausgangspunkt für Transformationen. Bei der Bewegung von Kinematischen Systemen wird er auch als Gelenkpunkt zweier verknüpfter Objekte verwendet.

Der Schwerpunkt eines Objekts kann verschoben oder gedreht werden.

Verknüpfung von Objekten

Die Möglichkeit, Objekte miteinander zu verknüpfen, erweist sich nicht nur in der Kinematik als hilfreich. Auch bei einfachen Transformationsanimationen kann es den Erstellungsaufwand verringern.

dass bei verknüpften Objekten nur noch ein Objekt animiert wird, und alle anderen Körper folgen diesem. Zur Animation komplexer kinematischer

Zusammenhänge ist die Verknüpfung von Körpern sogar ein Muss.

Time Configuration (Zeitkonfiguration)

Animationen werden entweder auf Video, Film oder nur zur Präsentation auf dem Bildschirm ausgegeben. Fast alle Medien besitzen unterschiedliche Bildwiederholraten. Selbst bei einem Videoband gibt es

von Land zu Land Unterschiede. Während wir in Deutschland die Fernsehnorm PAL, mit 25 Bildern pro Sekunde, einsetzen, haben die USA die NTSC-Norm, die mit 29.97 Bildern pro Sekunde arbeitet. Herkömmliches

Filmmaterial spielt Bilder meistens mit 24 Bildern pro Sekunde ab. Um am Bildschirm Animationen zu präsentieren, liegt es vor allem an dem vorhandenen Computer, wie viele Frames pro Sekunde abgespielt

werden können. Man kann sich zum Beispiel die Bildnummern auch einzeln anzeigen lassen.

Bewegungsbahnen

Legt ein Objekt die Strecke zwischen zwei Punkten zurück, kann diese Bahn sichtbar gemacht werden. Auf der Bahn können dann weitere Punkte eingefügt werden, um den Verlauf anzupassen.

Bewegungsbahnen

Track View (Spuransicht)

Die Spuransicht listet alle Objekte und Modifier auf und zeigt deren Animationsverlauf in einer Timeline an. Die Anzeige kann über Balken und Punkte oder über die Darstellung einer Funktionskurve erfolgen.

In der Spuransicht kann man die Eigenschaften von Keypunkten verändern, Punkte hinzufügen, löschen oder verschieben. Die Spuransicht ist ein zentrales Werkzeug, um Animationen zu erstellen und zu ändern.

Ghosting

Ghost-Bilder sind eine Methode beim Anzeigen von Drahtmodell-Ghost-Kopien eines animierten Objekts. Sie zeigen das Objekt vor und nach dem aktuellen Frame. Diese Methode der Darstellung dient vor allem

der Analyse von Bewegungen.

Helper Objects (Hilfsobjekte)

Helper Objects sind nicht-renderbare Objekte, die sich jedoch ansonsten wie normale Objekte verhalten. Vor allem bei komplexen Animationen oder bei Kinematischen Ketten sind diese meist unerlässlich.

Software

Lightwave

Lightwave 3D ist eine komplette und flexible Software-Lösung für Graphiken 3D und Animation. Lightwave 3D ist vielseitig genug um eine Komplettlösung für alle Arten von Projekte zu bilden.

Seit Jahren wird Lightwave im Fernsehen, im Film und in den Spielen benutzt, um Graphiken für Druck, Netz, industrielles Design und Architektur herzustellen. Lightwave 3D schließt viele der Werkzeuge mit ein:

Weich-Körperdynamik, Partikel, Haar und Pelz, um einige zu nennen. Lightwave 3D ist mit allen Werkzeugen versehen, die einem Künstler bereitgestellt werden müssen.

Die Liste der Filme und Serien bei denen u.a. LightWave 3D eingesetzt wurde kann sich sehen lassen: Star Trek: Voyager, seaQuest DSV, Babylon 5, Sliders, Hercules, Akte X, Titanic, The Simpsons, Robocop: The Series,

Star Trek: The Next Generation, M&M's Werbespot, etc.

Lightwave 3D besteht aus 2 Programmen die aber eng zusammenarbeiten. Zum einen der Lightwave Modeller, der die bekannte Ansichtsfensterstruktur hat, und Lightwave Layouter, der Animations- und Renderteil.

Modeler

LightWave 3D ermöglicht einfaches Modellieren auch von komplizierten Formen. Neben dem klassischen Modellieren mit Polygonen, ist auch das Modellieren von NURBS-Objekten möglich, bei denen 3D-Objekte ohne

Kantenübergänge erzeugt werden können. Der Subdivision Surface Modeler ist ein Echtzeit-Oberflächenmodeler in LightWave 3D und eine Mischform aus polygonalem und NURBS-Modelling für Oberflächen. Die Oberflächen

können mit Hilfe eines Werkzeugsets auf verschiedenste Weise manipuliert werden, auch in verschiedenen "Soft" Modi.

Das modellieren mit Digitalem Ton (Digital Clay) ist eine weitere Besonderheit im LightWave 3D Modeller. Modelliert wird dabei direkt auf dem Vertexlevel, indem gleich ganze Gruppen von Punkten oder Polygonen

mit verschiedenen Modellierungsmöglichkeiten manipuliert werden.

Die IntelligEntities ermöglichen das Erstellen "intelligenter" Objekte und zeitunabhängiger Modelle. IntelligEntities beinhalten Skelegons, Endomorphs, MultiMeshes und VMaps, die Ihre Objekte praktisch mit

einem "eigenem Bewußtsein" ausstatten.

Die Skelegons sind Platzhalter für Bones und können einem Objekt schon im Modeller zugeordnet werden. Alle Modellierungs-Werzeuge können so zum Aufbau und der Manipulation des Charakterskeletts verwendet werden.

Die Skelettstruktur wird im Objekt gesichert und wird dadurch bei der Modifikationen eines Charakters automatisch mit skaliert.

Für Gesichtsanimationen mit Lippensynchronität oder komplexe Morphingszenarien werden Endomorphs verwendet. Die Veränderungen des Gesichtsausdrucks oder der Lippen können vom Modell "erlernt" werden und

können nonlinear ineinander übergehen.

Mit MultiMeshes werden verschiedene Geometrieebenen innerhalb eines Objektes erstellt. Hierarchische Objekte werden als ein komplettes Modell mit allen definierten Beziehungen und Pivot-Daten gesichert.

Das HUB ist ein zentrales Datenlager für Postprozessmanipulation und Synchronisation und regelt den Datenaustausch zwischen dem Layouter und dem Modeller. Wird z.b. ein im Layouter befindliches Objekt in den

Modeler gezogen, wird jede Änderung im Modeler gleichzeitig im Layouter synchronisiert. Modeller und Layouter sind dabei frei konfigurierbar.

Der Layouter ermöglicht natürlich auch verschiedene Perspektiven und Kameras.

Oberflächen und Texturen

Mit dem Echtzeit Subdivision Oberflächenmodeller in LightWave 3D lassen sich komplexe Oberflächen und Texturen erstellen. Man kann zwischen Image Maps, Prozeduralen Texturen und Gradient wählen. Das Ändern von

Texturen und parametrischen Objekteigenschaften erfolgt einfach per Drag & Drop.

Alle Texturtypen können in unbegrenzter Zahl und auf unterschiedlichste Weise übereinandergelegt von einer zur nächsten Textur überblendet werden, und zwar in Echtzeit. Sogar das Erstellen komplexer Landschaften

ist mit LightWave 3D möglich. Die Texturenvergabe im Modeler erfolgt durch ein TextureGuide Werkzeug. Man positioniert, skaliert und dreht die Texturen mit Hilfe eines rechteckigen Dummys.

Die Textureigenschaften eines Kanals können durch einfaches Kopieren in einen anderen Kanal eingefügt werden um mehrere Kanäle so einfach angepasst werden. Eine grosse Sammlung von natürlichen Shadern macht die

Erzeugung von Oberflächen wie Schnee, Wasser oder Rost einfach. Mit Texture Motion können Texturen sogar einem Bewegungspfad zugeordnet werden.

Lightwave Modeler

Animation

LightWave 3D ist ein äusserst flexibles Animationssystem mit dem alle erdenklichen 3D-Animationen realistisch dargestellt und mit Spezialeffekten ausgestattet werden können.

Die Kombination von Inverse Kinematik mit der direkten Kontrolle von Forward Kinematik trägt ihren Teil dazu bei. Inverse und Forward Kinematik sind über die Mixmodi kontrollierbar, die Begrenzungen für beide

Animationsmodi sind interaktiv einstellbar.

Das Set Driven Key erlaubt einem Objekt einem anderen auf einer bestimmte Achse zu folgen, auch zeitversetzt. Das lässt sich auch mit anderen Eigenschaften verknüpfen - z.b. kann so die Farbänderung einer

Objektoberfläche in Abhängigkeit von der Rotation eines anderen Objektes erfolgen.

Auch das Animieren von Gras oder Kleidung im Wind ist in LightWave 3D möglich. Mit Soft Body Dynamics simuliert man weiche, bewegliche Körper unter dem Einfluss von Gravitation, Wind und anderer natürlicher Kräfte,

die alle separat einstellbar sind.

Die Soft Bodies arbeiten auch mit dem Partikelsystem zusammen, z.b. in Abhängigkeit der Windeigenschaften eines erzeugten Sturms. Jeder einzelne Partikel für volumetrischen Effekte wie Explosionen, Feuer, Rauch,

Funken, Wolken, Stürmen , Schneegestöber etc. ist einstellbar und kontrollierbar.

Animierte Objekte können innerhalb einer Szene verlinkt, verbunden oder gelenkt werden.

Der Nonlineare Kurveneditor harmoniert mit den Kinematik Werkzeugen. Arbeiten Sie simultan an mehreren Kurven von jedem Objekt der Szene aus. Die Kurven können dabei mit mehreren Tangententypen pro Kurve z.b. Linear,

Bezier, Stepped, Hermite und TCB, erzeugt werden.

Rendering

Bei LightWave 3D befriedigt auch der flexible Renderer höchste Ansprüche und liefert schnelle, qualitativ hochwertige Ergebnisse. Der Renderer unterstützt Motion Blur (Bewegungsunschärfe), Partikel Blur, verschiedene

Stufen von Antialiasing (Kantenglättung), uvm. Field Rendering, Raytraycing, True Radiosity, Caustics und HyperVoxels bilden ein vielseitiges Renderingsystem. Auch komplexe Berechnungen wie Nebel, Schatten, Brechungen,

Spiegelungen und volumetrischer Effekte werden mit hoher Geschwindigkeit ausgeführt.

Hinter HyperVoxels steht eine volumetrische Rendertechnologie für die Erzeugung detaillierter 3D-Oberflächen, die mit verschiedenen Hypertexturen oder algorithmischen Texturen beeinflusst werden können. Hinzu kommt, daß

HyperVoxels sich entlang einer Achse oder des Geschwindigkeitsvektors verzerren können, was z.b. Explosionen um einiges realistischer werden lässt.

Lightwave 3D

3DS Max

3ds max™ ist die weltweit meist verkaufte professionelle Software zur 3D-Modellierung, Animation und dem Rendering. Es bietet dem 3D-Artist eine einheitliche, objektorientierte Plattform für Visual Effekts, Charakter

Animation und für Spiele. Seit seiner Einführung im Jahr 1995 hat 3ds max mehr als 65 Auszeichnungen der Industrie erhalten und ist das Werkzeug für mehr als 140.000 3D-Artists auf dem Windows® Betriebsystem.

3ds max 4 bietet dem CG-Profi zukunftsweisende Werkzeuge zur Charakter Animation, Spieleentwicklung der Next Generation und der Produktion von Spezialeffekten. Zahlreiche einzigartig neue Ergänzungen und Verbesserung der

Software-Architektur tragen diesen drei Anforderungen Rechnung und machen 3ds max 4 zum Werkzeug der Animationsindustrie. Ein fein abgestimmtes Animationssystem mit den fortschrittlichsten Werkzeugen zum Modellieren und

die überarbeitete Charakter Animation erlauben dem 3D-Artist seine Ideen zum Leben zu erwecken. Die interaktive Anzeige, leichte Erweiterbarkeit, Modellierungswerkzeuge und die offene Architektur sind auf dem neuesten Stand

der Technik. Damit wird 3ds max 4 zu einem vorrangigen 3D-Content-Creation Werkzeug für die Entwicklung von Spielen. Eine fotorealistisch arbeitende ActiveShade-Render-Engine, das produktionsbewährte Netzwerk-Render-System,

und die enge Integration der Post-Produktions Möglichkeiten mit combustion™ (discreets Desktop 2D/3D Programm) machen 3ds max 4 zu einem effizienten und produktiven Werkzeug für Visual Effekts in Film und TV.

Charakter Animation:

- Neue, ausbaubare IK-Architektur zur erweiterten Kontrolle der Charaktere

- Äußerste Flexibilität des Charakters durch Blended-IK und FK-Lösungen

- Revolutionäres schattiertes Bone-System bietet Volumen für Skinning, stauchen/dehnen und in der Vorschau

- Angle-Deformers zur akkuraten Skin-Verformung pro Gelenkwinkel, einschließlich Joint, Bulge und Morph

- Soft-Body-Federdynamik für Sekundärbewegungen

- Anpaßbare Slider-Manipulatoren zur flexiblen Charakterkontrolle

- Gewichtetes Begrenzungssystem für erweiterte Gelenkfreiheits- grade der Charaktere

Benutzeroberfläche bei 3DS Max

Cinema 4D

Mit all den Möglichkeiten, die Cinema 4D 7 XL bietet, bleibt die Benutzeroberfläche beliebig umgestaltbar. Selbst Iconleisten und Icons lassen sich weiterhin individuell definieren.

Sie können sich leicht eine individuelle Version erstellen. Die gesamte Oberfläche basiert auf der hauseigenen Skriptsprache Coffee, die die Integration von Plugins in die Oberfläche erlaubt.

Im Renderbereich hat Cinema 7.1 Xl einiges zugelegt. Sie können jetzt ohne Probleme indirekte Beleuchtungen in Ihre Entwürfe mit einbeziehen. Mit Radiosity werden diffuse Reflexion berücksichtigt die photorealistische Effekte verstärken. Bisher konnte man zwar selbststrahlende Materialien verwenden, mit Radiosity merkt man jetzt deutlich, dass diese Materialien eigentlich bisher eigentlich selber kein Licht abgeben konnten. Mit der Version 7 XL ist das anders. Man kann jetzt eine Szene durch Material ausleuchten lassen.

Eine weitere Rendermöglichkeit, die Caustics ist eine Option für Feinrenderer und Liebhaber. Es ist nicht so einfach die richtigen Einstellungen für den Effekt zu finden. Es sind die Lichteffekte, die entstehen, wenn Licht durchscheinendes Material durchläuft und dabei den Gesetzen der Lichtbrechung wie Bündelung und Zerstreung gehorcht. Man hat die Möglichkeit jetzt mit diesem Effekt, den physikalisch korrekten Lichtweg durch mehrere Linsen und Materialien zu verfolgen. Wie es mit allen highend Einstellungen ist, brauchen Sie hier Geduld und eine Menge Fingerspitzengefühl um dem Programm das zu entlocken, was es alles leisten kann.

Das Multipass-Rendering lässt zu, dass Man auf alle Bild- und Materialkanäle in Form einer Photoshopdatei zu greifen kann. Für verschiedene Lichtquellen lassen sich ohne Schwierigkeiten separate Kanäle erzeugen. Man kann im Nachhinein über die einzelnen Kanäle mit dem Photoshop manipulieren, gezielte Veränderungen an Details einbringen.

Das Programm hat an vielen Stellen professionelle Erweiterungen intergriert und vorangetrieben. Die Änderungen und Erweiterungen haben es diesmal in sich und bedürfen einer Menge an Wissen und Erfahrung um der Dinge, die dargestellt und gerendert werden sollen. Wer photorealistisch arbeiten möchte, der muss einiges aus und von der Realität kennen, um das Programm dazu veranlassen, es nach zu gestalten.

Benutzeroberfläche bei 3DS Max

Quellen

Literatur

- Inside LightWave 7 - Dan Ablan - New Riders Publishing - Dec. 2001

- 3D Design - Arndt von Koenigsmarck - Midas Verlag - 2000

- 3ds max 4 - Istvan Velsz - Addison Wesley - 2002

WWW